¿Qué es un token? Cómo funciona y para que sirve en ChatGPT

Los tokens en ChatGPT

Los tokens son elementos fundamentales en la tecnología blockchain y en el mundo de las criptomonedas. En el caso de ChatGPT, un token es una unidad digital que representa un valor o activo específico dentro de la plataforma. La función principal de los tokens en ChatGPT es facilitar la interacción entre usuarios y el acceso a funciones exclusivas.

Para comprender cómo funcionan los tokens en ChatGPT, es esencial conocer su estructura y las ventajas que ofrecen. A través de la tecnología blockchain, los tokens se crean, se almacenan y se transfieren de manera segura, garantizando la integridad y la transparencia de las transacciones.

- Funcionalidad: Los tokens en ChatGPT pueden utilizarse para desbloquear características premium, acceder a servicios exclusivos o recompensar la participación activa de los usuarios.

- Seguridad: La tecnología subyacente de los tokens en ChatGPT utiliza protocolos de encriptación avanzados para proteger la información y garantizar la privacidad de los usuarios.

- Interoperabilidad: Los tokens en ChatGPT pueden integrarse con otras plataformas y aplicaciones, permitiendo una mayor versatilidad y posibilidades de uso.

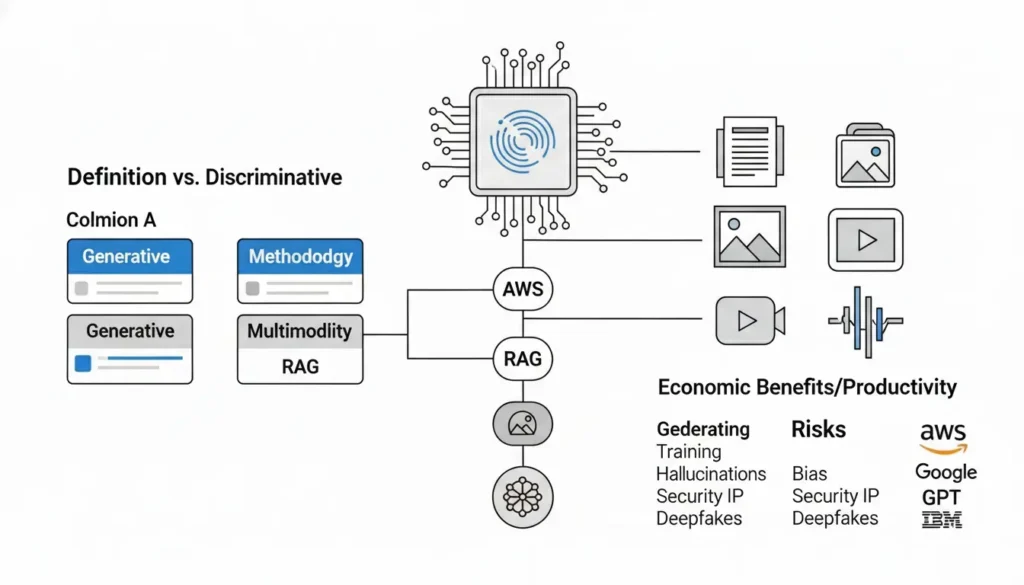

Definición de token en inteligencia artificial

En el ámbito de la inteligencia artificial, un token se refiere a una unidad básica de procesamiento que se utiliza para representar una palabra, símbolo o elemento de un texto. En el contexto del procesamiento del lenguaje natural (NLP), los tokens son esenciales para descomponer un texto en componentes más pequeños, facilitando su análisis y comprensión por parte de los algoritmos de inteligencia artificial.

Los tokens en inteligencia artificial se generan mediante el proceso de tokenización, que consiste en dividir un texto en fragmentos más pequeños, eliminando posibles caracteres no deseados o espacios en blanco. Cada token representa una unidad significativa de información que puede ser utilizada para entrenar modelos de IA, realizar análisis de texto, clasificación de documentos, entre otras tareas.

Además, los tokens en inteligencia artificial juegan un papel fundamental en la creación y entrenamiento de modelos de lenguaje, como los sistemas de procesamiento de lenguaje natural basados en redes neuronales. Estos modelos utilizan los tokens como entrada para aprender patrones lingüísticos y contextuales, lo que permite a la IA entender y generar texto de manera más precisa.

- Funciones principales de los tokens en inteligencia artificial:

- Segmentación de texto.

- Análisis de sentimiento.

- Extracción de información.

- Generación de texto.

- Clasificación de texto.

Importancia de los tokens en los modelos de lenguaje como chatgpt

Los tokens desempeñan un papel fundamental en los modelos de lenguaje como ChatGPT, ya que permiten descomponer el texto en unidades más pequeñas y significativas para su procesamiento. En el contexto de ChatGPT, los tokens son la base sobre la cual se construye la comprensión y generación de texto.

Al dividir el texto en tokens, se facilita la tarea de analizar la estructura y el significado del lenguaje. Cada token representa una palabra, un segmento de palabra o un carácter, lo que permite al modelo de lenguaje entender y generar texto de manera más precisa y coherente.

Además, los tokens son esenciales para la tokenización, que es el proceso de convertir texto en secuencias de tokens comprensibles para el modelo de lenguaje. Esta tokenización es crucial para que ChatGPT pueda interpretar y producir respuestas coherentes en conversaciones.

- Mejora la precisión: Al utilizar tokens, los modelos de lenguaje como ChatGPT pueden mejorar su precisión en la comprensión del lenguaje natural, lo que les permite generar respuestas más relevantes y contextuales.

- Facilita el entrenamiento: Los tokens simplifican el procesamiento del texto durante el entrenamiento del modelo, lo que resulta en un aprendizaje más eficiente y una mejor capacidad de generación de texto.

- Optimiza el rendimiento: La utilización de tokens en ChatGPT contribuye a optimizar el rendimiento del modelo, permitiéndole manejar grandes cantidades de datos de forma más efectiva y generar respuestas más coherentes.

¿Qué es un token?

En el ámbito de la informática, un token es una cadena de caracteres que sirve como unidad indivisible de datos. Es utilizado en diversos contextos, como la seguridad cibernética, las redes informáticas y la criptografía.

En el contexto de la tecnología blockchain, un token representa un activo digital fungible o no fungible que puede ser intercambiado, almacenado y transferido de forma segura. Los tokens pueden tener diferentes funciones, como facilitar transacciones, representar derechos de propiedad o acceso a servicios específicos.

- Tokens fungibles: Son aquellos que tienen un valor intercambiable con otros tokens del mismo tipo, como por ejemplo las criptomonedas como Bitcoin o Ethereum.

- Tokens no fungibles: Representan activos únicos e indivisibles, como obras de arte digitales, bienes raíces virtuales o coleccionables digitales.

- Tokenización de activos: El proceso de convertir activos físicos o virtuales en tokens digitales, lo que permite una mayor liquidez y transferencia de estos activos en entornos digitales.

Explicación detallada de lo que es un token en el contexto de inteligencia artificial

En el ámbito de la inteligencia artificial, un token se refiere a una unidad básica de procesamiento que se utiliza para representar elementos individuales de información, como palabras o caracteres, en un texto o secuencia de datos. Estos tokens son fundamentales en el campo del procesamiento del lenguaje natural y en el entrenamiento de modelos de aprendizaje automático, como ChatGPT.

Cada token representa una unidad significativa de información que se utiliza para alimentar los modelos de inteligencia artificial. Por ejemplo, en el contexto del procesamiento del lenguaje natural, cada palabra en una oración se convierte en un token individual. Los tokens permiten a los modelos de inteligencia artificial entender y trabajar con el texto de manera más eficiente y precisa.

Para el funcionamiento adecuado de los algoritmos de inteligencia artificial, es crucial preprocesar el texto y convertirlo en una secuencia de tokens que el modelo pueda comprender y procesar. Este proceso implica dividir el texto en unidades más pequeñas, como palabras o subsecuencias de caracteres, y asignar un token único a cada una de ellas.

- Tokenización: El proceso de convertir el texto en tokens se conoce como tokenización. Permite descomponer el texto en unidades significativas para que los modelos de inteligencia artificial puedan realizar operaciones de análisis y generación de texto de manera más efectiva.

- Representación numérica: Cada token se representa numéricamente mediante un índice único que lo relaciona con un vector en un espacio dimensional. Esta representación numérica es fundamental para el procesamiento de texto en modelos de inteligencia artificial.

- Utilidad en ChatGPT: En el contexto específico de ChatGPT, los tokens se utilizan para codificar y decodificar las interacciones de lenguaje natural entre el usuario y el modelo. Cada token captura información crucial que guía la generación de respuestas coherentes en tiempo real.

Funcionamiento de un token en ChatGPT

En ChatGPT, los tokens son unidades básicas de texto o palabras que se utilizan para alimentar el modelo de lenguaje. Cada token representa una parte específica de un texto que se procesa y analiza para generar respuestas coherentes y contextualmente precisas.

El funcionamiento de un token en ChatGPT es crucial para la comprensión y generación de texto fluido. Cuando se envía un mensaje al modelo, se descompone en tokens individuales que el sistema interpreta y utiliza para generar una respuesta adecuada.

Los tokens permiten al modelo de lenguaje analizar y contextualizar la información aportada, lo que mejora la calidad y relevancia de las respuestas generadas por ChatGPT.

- Segmentación: Los tokens ayudan a segmentar y organizar el texto de entrada en unidades significativas para que el modelo pueda procesarlo de manera efectiva.

- Contextualización: Al desglosar el contenido en tokens, ChatGPT puede comprender mejor el contexto y la intención detrás de cada palabra o conjunto de palabras, lo que resulta en respuestas más coherentes y precisas.

- Generación de respuestas: El uso eficiente de tokens en ChatGPT influye directamente en la capacidad del modelo para generar respuestas relevantes y contextualmente adecuadas a las consultas de los usuarios.

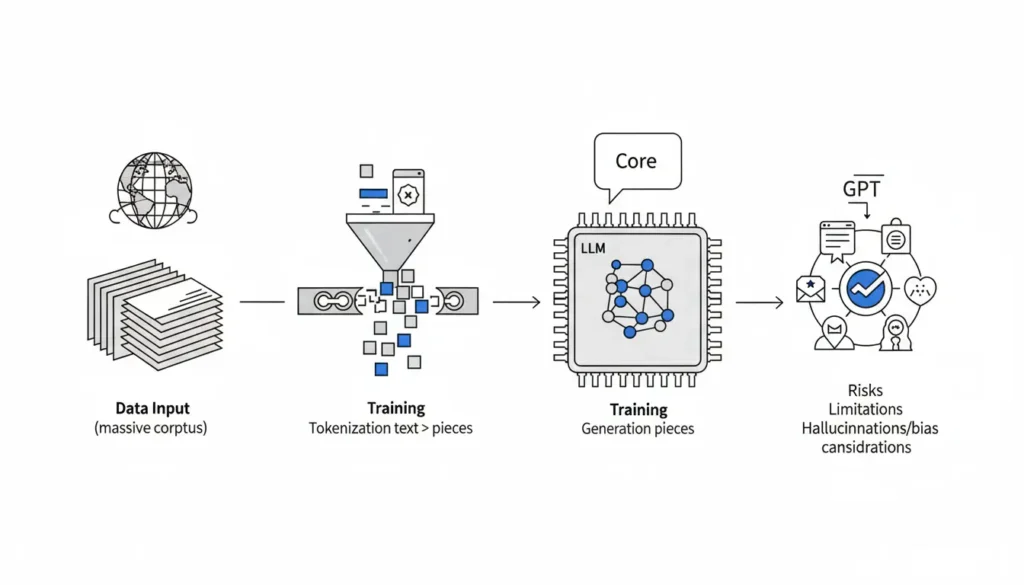

Proceso de tokenización en chatgpt

El proceso de tokenización en ChatGPT es fundamental para el funcionamiento del modelo de generación de lenguaje. A través de la tokenización se transforma un texto en una secuencia de tokens o unidades más pequeñas, que generalmente corresponden a palabras o subpalabras.

En el caso de ChatGPT, se implementa un proceso avanzado de tokenización que involucra la división del texto en tokens, la conversión de estos tokens a representaciones numéricas y la construcción de vectores de embeddings que servirán como entrada al modelo.

La tokenización en ChatGPT utiliza un vocabulario predefinido que contiene una gran cantidad de tokens únicos, lo que permite al modelo procesar una amplia variedad de palabras y frases de manera eficiente.

- División del texto: El texto de entrada se divide en tokens utilizando técnicas como la segmentación de palabras y la división de palabras en subtokens.

- Conversión a representaciones numéricas: Cada token se mapea a un identificador único en el vocabulario, lo que permite representar el texto como una secuencia de números.

- Construcción de embeddings: Los tokens se transforman en vectores de embeddings, que son representaciones numéricas densas que capturan información semántica sobre las palabras.

Roles y usos de los tokens en este contexto

Los tokens desempeñan un papel fundamental en el funcionamiento de ChatGPT, ya que son unidades de texto o señales que se utilizan para delimitar y representar diferentes elementos dentro del sistema. En este contexto específico, los tokens sirven para:

- Segmentar la información: Los tokens permiten dividir el texto en unidades más pequeñas, facilitando el procesamiento y análisis por parte del modelo de lenguaje de ChatGPT.

- Generar respuestas coherentes: Al utilizar tokens específicos para marcar preguntas, respuestas o contextos, el modelo es capaz de generar respuestas más coherentes y contextualmente adecuadas.

- Identificar entidades: Mediante el uso de tokens especiales, es posible identificar y asignar significado a entidades específicas dentro de las conversaciones, lo que mejora la calidad de las respuestas generadas.

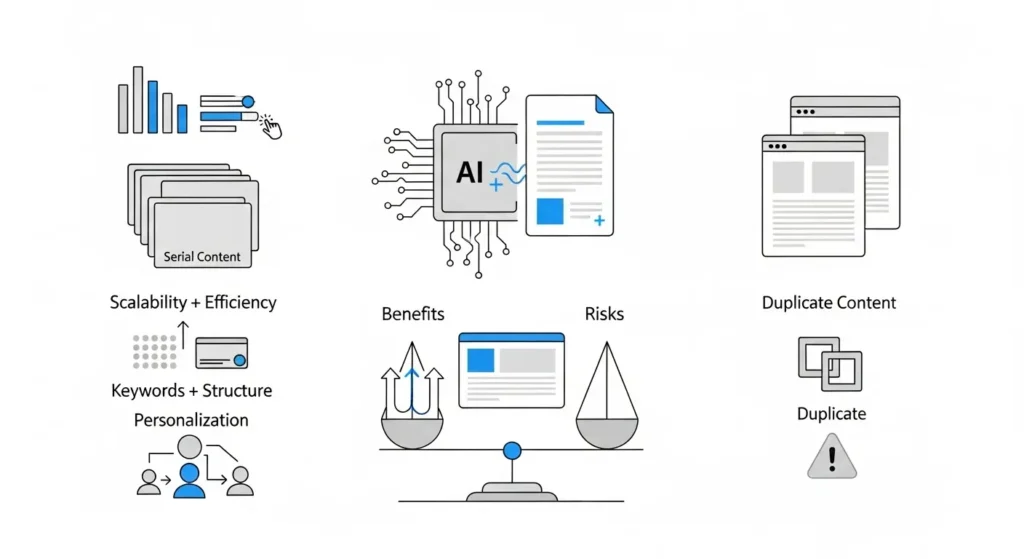

Beneficios de los tokens en la inteligencia artificial

Los tokens desempeñan un papel crucial en el campo de la inteligencia artificial al permitir el procesamiento y entendimiento de lenguaje natural. A continuación, se detallan algunos de los beneficios más destacados que los tokens aportan en este ámbito:

- Facilitan la representación de texto: Los tokens permiten representar las palabras de un texto de manera estructurada, facilitando su análisis y manipulación por parte de los algoritmos de inteligencia artificial.

- Mejoran la precisión de los modelos: Al descomponer el texto en tokens, los modelos de inteligencia artificial pueden capturar con mayor precisión la información semántica y gramatical de un documento, lo que se traduce en resultados más precisos.

- Optimizan el procesamiento del lenguaje natural: Al utilizar tokens, las tareas de procesamiento del lenguaje natural, como la clasificación de texto o la generación de texto, se vuelven más eficientes y efectivas al trabajar a nivel de unidades semánticas más pequeñas.

- Favorecen el aprendizaje de las máquinas: Los tokens proporcionan a los modelos de inteligencia artificial una representación más detallada de las palabras, lo que contribuye a mejorar su capacidad de aprendizaje y comprensión del lenguaje humano.

Mejora en la comprensión del contexto

Para comprender mejor el contexto en el que se utiliza un token en ChatGPT, es fundamental tener en cuenta que un token no es simplemente una cadena de caracteres aleatoria, sino que representa una unidad significativa dentro del proceso de generación de texto por parte del modelo de lenguaje.

Los tokens son fragmentos de información que permiten al modelo descomponer el texto en elementos más pequeños y manejables, lo que facilita su procesamiento y comprensión. Cada token puede corresponder a una palabra, símbolo o incluso a una parte de una palabra, dependiendo de cómo esté configurado el sistema.

Al dividir el texto en tokens, ChatGPT puede analizar de manera más eficiente el contenido y generar respuestas coherentes y contextualmente relevantes. Cada token aporta información específica que influye en la salida final del modelo, lo que mejora la calidad de las respuestas generadas.

- Mejora en la precisión: Al tener en cuenta el contexto de cada token, el modelo puede generar respuestas más precisas y relevantes a las consultas de los usuarios.

- Mayor coherencia: La utilización de tokens ayuda a mantener la coherencia en el texto generado, ya que cada elemento contribuye a la comprensión global del mensaje.

- Optimización del procesamiento: Dividir el texto en tokens facilita el procesamiento del modelo, permitiéndole analizar la información de forma más efectiva y generar respuestas más rápidas.

Mayor eficiencia en el procesamiento del lenguaje natural

El procesamiento del lenguaje natural (NLP) ha experimentado avances significativos en los últimos años, permitiendo la creación de modelos como ChatGPT que pueden comprender y generar texto de manera sorprendentemente precisa. Para mejorar la eficiencia en este proceso, se han aplicado diversas técnicas y estrategias que optimizan el rendimiento de los algoritmos utilizados.

A continuación, se presentan algunas de las prácticas clave que contribuyen a una mayor eficiencia en el procesamiento del lenguaje natural:

- Uso de modelos pre-entrenados: Los modelos de lenguaje pre-entrenados, como GPT (Generative Pre-trained Transformer), han demostrado ser altamente efectivos al capturar patrones lingüísticos complejos. Al utilizar estos modelos como base, se reduce la necesidad de entrenar desde cero, lo que acelera significativamente el proceso de desarrollo de aplicaciones NLP.

- Transfer Learning: La técnica de Transfer Learning ha revolucionado la forma en que se abordan los problemas de NLP. Al transferir conocimientos de modelos entrenados en tareas similares, se logra mejorar la eficiencia y el rendimiento de los nuevos modelos, reduciendo el tiempo y los recursos necesarios para su desarrollo.

- Optimización del hardware: El uso de hardware especializado, como unidades de procesamiento gráfico (GPU) y unidades de procesamiento tensorial (TPU), permite acelerar los cálculos necesarios para el procesamiento de grandes volúmenes de texto. Esta optimización hardware/software contribuye a una mayor eficiencia en el NLP.

- Técnicas de compresión de modelos: La compresión de modelos consiste en reducir el tamaño de los modelos de lenguaje sin comprometer su rendimiento. Mediante técnicas como la poda de parámetros redundantes o la cuantización de pesos, se logra disminuir el consumo de recursos computacionales, mejorando la eficiencia en el procesamiento del lenguaje natural.

Conclusiones sobre los tokens

Los tokens son elementos fundamentales en el funcionamiento de ChatGPT y constituyen la base de la comunicación entre el sistema y los usuarios. Al ser unidades de información autenticadas y seguras, los tokens garantizan la integridad y confidencialidad de los datos transmitidos.

Además, los tokens facilitan la interacción entre los usuarios y ChatGPT al permitir el acceso controlado a funcionalidades específicas y asegurar la identidad de los participantes. Su uso adecuado contribuye significativamente a la protección de la privacidad y la seguridad de la información.

En conclusión, comprender qué es un token, cómo funciona y para qué sirve en el contexto de ChatGPT es esencial para aprovechar al máximo las capacidades de esta herramienta de inteligencia artificial y garantizar una comunicación eficiente y segura.

Resumen de la importancia y funcionamiento de los tokens en la inteligencia artificial y en chatgpt

Los tokens desempeñan un papel fundamental en la inteligencia artificial y especialmente en modelos como ChatGPT. En el contexto de la IA, un token se refiere a una unidad mínima de texto que se utiliza para procesar y comprender el lenguaje natural. Estos tokens son la base sobre la cual se construyen los modelos de IA para llevar a cabo tareas como generación de texto.

En el caso específico de ChatGPT, los tokens son esenciales para que el modelo pueda interpretar y generar respuestas coherentes a partir de las interacciones con los usuarios. Cada palabra o símbolo en una conversación se convierte en un token único que el modelo utiliza para analizar el contexto y producir una respuesta adecuada.

El funcionamiento de los tokens en ChatGPT implica la segmentación del texto de entrada en unidades significativas que puedan ser procesadas de manera eficiente por el modelo. Esta segmentación facilita la generación de respuestas coherentes y contextualmente relevantes, mejorando la calidad de la interacción entre el usuario y la IA.

- Importancia en la IA: Los tokens permiten a los modelos de IA comprender y generar texto de manera más precisa y coherente.

- Funcionamiento en ChatGPT: Los tokens son utilizados para procesar y analizar el texto de las conversaciones, facilitando la generación de respuestas contextualmente adecuadas.

Los tokens son elementos clave en la inteligencia artificial y en modelos como ChatGPT, permitiendo una mejor comprensión del lenguaje natural y mayor eficiencia en el procesamiento.