Araña Web: Descubre su Importancia y Funcionamiento

Introducción a las arañas web

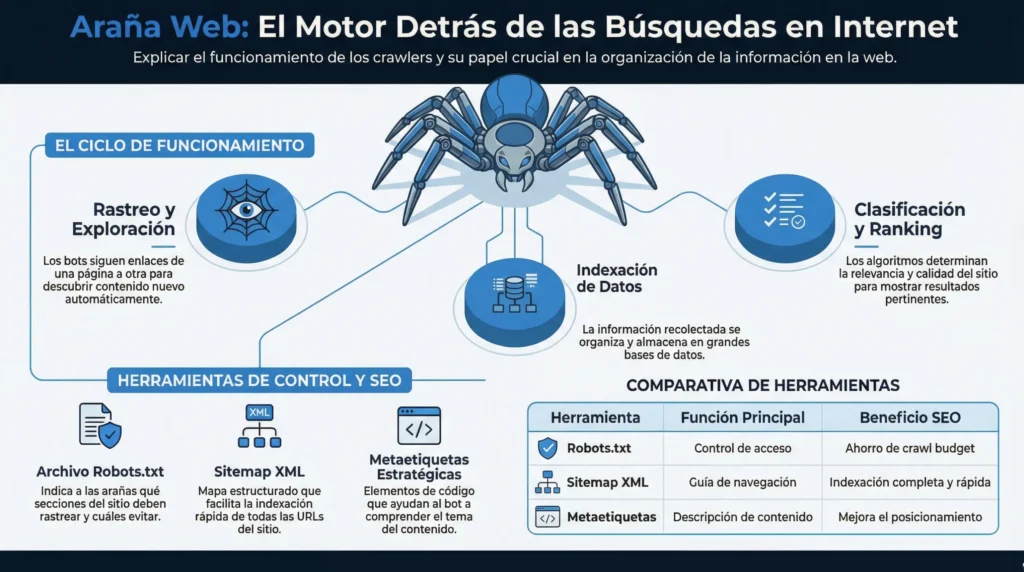

Las arañas web, también conocidas como crawlers o bots, son programas informáticos diseñados para recorrer automáticamente la web y recopilar información sobre las páginas que visitan. Su función principal es indexar y clasificar el contenido de los sitios web para que los motores de búsqueda puedan mostrar los resultados relevantes a los usuarios.

Estas arañas utilizan algoritmos sofisticados para analizar el contenido de las páginas, seguir enlaces, identificar palabras clave y determinar la relevancia y calidad de cada sitio web. Gracias a su labor, los motores de búsqueda pueden ofrecer resultados precisos y actualizados a los usuarios que realizan búsquedas en Internet.

- Rastreo: Las arañas web recorren la web siguiendo enlaces de una página a otra para descubrir y analizar nuevo contenido.

- Indexación: Una vez recopilada la información, las arañas web la organizan y almacenan en los índices de los motores de búsqueda.

- Clasificación: Con base en diferentes criterios, las arañas determinan la relevancia y calidad de cada página para mostrar los resultados más pertinentes a los usuarios.

Definición de araña web

Las arañas web, también conocidas como crawlers o bots, son programas informáticos desarrollados para recorrer de forma automatizada el contenido de páginas web en busca de información. Su función principal es indexar y clasificar el contenido de internet para facilitar su posterior recuperación por parte de los motores de búsqueda.

Estas arañas recorren constantemente la red, siguiendo enlaces de una página a otra, analizando el código y extrayendo datos relevantes como palabras clave, descripciones y enlaces. Esta información es luego utilizada por los motores de búsqueda para mostrar resultados relevantes a los usuarios.

En resumen, las arañas web juegan un papel fundamental en la organización y accesibilidad de la información en internet, contribuyendo a que los usuarios puedan encontrar fácilmente el contenido que están buscando.

Importancia de las arañas web

Las arañas web, también conocidas como crawlers o bots, desempeñan un papel fundamental en el funcionamiento de los motores de búsqueda. Estas herramientas son responsables de rastrear y explorar todas las páginas web disponibles en Internet para indexar su contenido y luego mostrar los resultados relevantes a los usuarios que realizan búsquedas.

La importancia de las arañas web radica en:

- Facilitar el acceso a la información: Al rastrear el contenido de manera eficiente, las arañas web permiten que los motores de búsqueda muestren resultados relevantes y actualizados a los usuarios.

- Mejorar la visibilidad en línea: Si una página web no es indexada por las arañas, es poco probable que aparezca en los resultados de búsqueda, lo que afectaría su visibilidad y alcance.

- Optimización del SEO: Las arañas web ayudan a identificar errores técnicos y de contenido en una página, lo que permite a los propietarios de sitios web mejorar su SEO y aumentar su ranking en los motores de búsqueda.

- Indexación de contenido complejo: Gracias a las arañas web, incluso el contenido dinámico o protegido por contraseñas puede ser indexado y mostrado en los resultados de búsqueda.

Funcionamiento de las arañas web

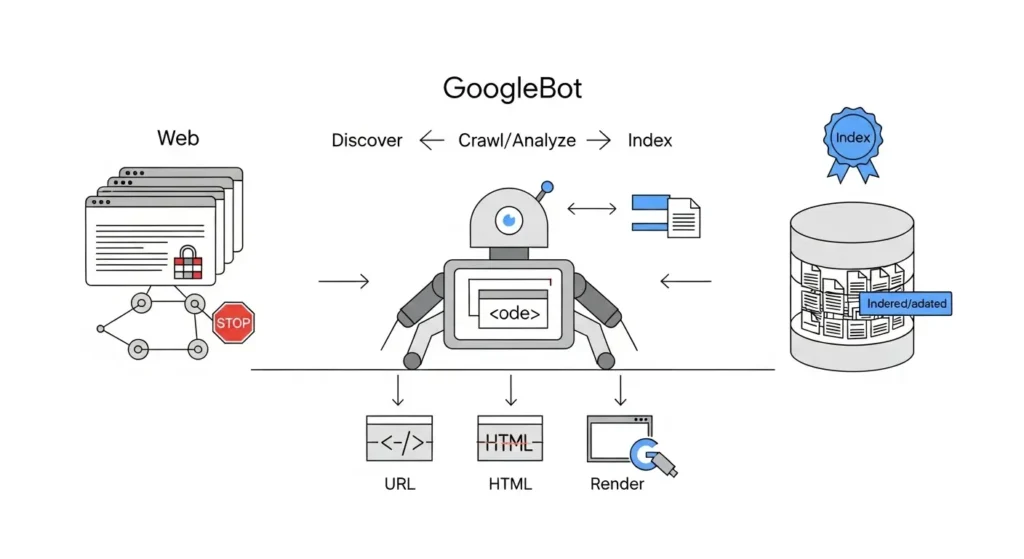

Las arañas web, también conocidas como web crawlers o spiders, son herramientas utilizadas por los motores de búsqueda para explorar y recopilar información de manera sistemática en internet. Estos programas automatizados siguen enlaces de una página a otra, indexando y catalogando el contenido para facilitar su posterior recuperación.

El funcionamiento de las arañas web se basa en algoritmos complejos que determinan qué páginas visitar, con qué frecuencia hacerlo y cómo indexar el contenido. Estos algoritmos consideran factores como la relevancia, la autoridad del sitio, la frescura del contenido y la optimización para motores de búsqueda.

Una vez que una araña web accede a una página, analiza su estructura, palabras clave, metaetiquetas y otros elementos para comprender de qué trata el contenido y cómo clasificarlo. Posteriormente, indexa la información en una base de datos para que los usuarios puedan encontrarla mediante consultas de búsqueda.

- Exploración: Las arañas web comienzan en una página inicial y siguen los hipervínculos para recorrer la web.

- Indexación: Procesan y almacenan la información recopilada para su posterior recuperación.

- Actualización: Las arañas web revisan periódicamente las páginas indexadas para mantener la información actualizada.

En resumen, las arañas web son fundamentales para el funcionamiento de los motores de búsqueda, asegurando que los usuarios puedan acceder a información relevante y actualizada de forma rápida y eficiente en la vasta red de internet.

Rastreo de sitios web

El rastreo de sitios web es una actividad fundamental para garantizar que todos los contenidos de un sitio sean indexados por los motores de búsqueda. Una araña web, también conocida como spider o bot, es la encargada de llevar a cabo este proceso.

La araña web recorre de forma metódica todas las páginas de un sitio, siguiendo enlaces internos y externos para descubrir nuevo contenido. Es importante asegurarse de que todos los enlaces sean accesibles y que no haya bloqueos que impidan el rastreo.

Para optimizar el rastreo de un sitio web, es recomendable tener una estructura clara y organizada, utilizar un archivo robots.txt para controlar qué secciones deben ser rastreadas y crear un sitemap XML para facilitar la indexación de todas las páginas.

Además, es fundamental monitorear regularmente el rendimiento de las arañas web, identificar posibles errores de rastreo y corregirlos rápidamente para garantizar que todas las páginas sean indexadas correctamente.

- Consejos para mejorar el rastreo de sitios web:

- Optimizar la velocidad de carga de las páginas.

- Evitar el contenido duplicado.

- Utilizar etiquetas meta robots para controlar el rastreo de páginas específicas.

- Actualizar el contenido regularmente para mantenerlo relevante.

Indexación de contenido

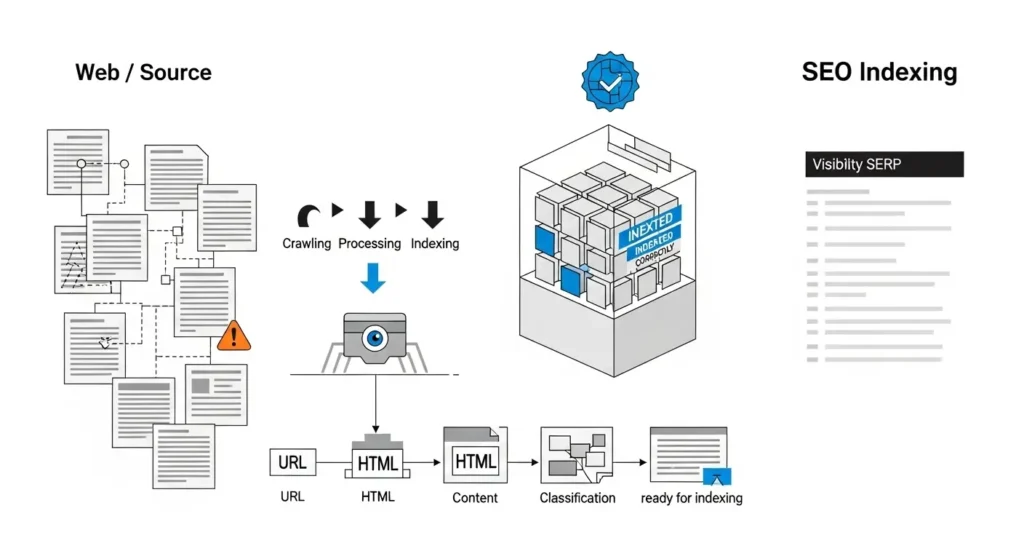

La indexación de contenido es una parte fundamental en el funcionamiento de una araña web. Este proceso consiste en que los motores de búsqueda recopilen, almacenen y clasifiquen la información de todas las páginas web disponibles en la red.

Para lograr una correcta indexación de contenido, es importante seguir buenas prácticas de SEO, como la optimización de palabras clave, la creación de contenido original y de calidad, el uso de metaetiquetas adecuadas y una estructura de enlaces sólida.

Es fundamental que el contenido de un sitio web sea indexado de manera eficiente, ya que esto facilita que las arañas web recorran y analicen todas las páginas, permitiendo que el sitio aparezca en los resultados de búsqueda de manera relevante.

- Palabras clave: Utiliza palabras clave relevantes y específicas en tu contenido para que sea indexado correctamente por los motores de búsqueda.

- Contenido único: Evita duplicar contenido en tu sitio web, ya que esto puede afectar negativamente su indexación y posicionamiento en los resultados de búsqueda.

- Mapa del sitio: Utiliza un mapa del sitio XML para facilitar la indexación de todas las páginas de tu sitio web de manera estructurada y organizada.

Procesamiento de datos

Cuando una araña web recopila información de páginas web, esta se almacena en un formato crudo que luego necesita ser procesado. El procesamiento de datos es una etapa crucial en el funcionamiento de una araña web, ya que se encarga de organizar, limpiar y estructurar la información recolectada para que sea útil y accesible.

En esta fase, los datos se someten a técnicas como el análisis de texto, la eliminación de duplicados, la normalización de formatos y la extracción de información relevante. Además, se pueden aplicar algoritmos de clasificación y etiquetado para categorizar los datos de forma inteligente.

El procesamiento de datos en una araña web es fundamental para poder realizar búsquedas rápidas y precisas, generar estadísticas, identificar tendencias y patrones, y crear índices de contenido. Todo este trabajo de procesamiento garantiza que la información recopilada sea de calidad y esté lista para ser utilizada en diferentes aplicaciones.

- Análisis de texto: Identificar palabras clave, frases relevantes y contexto.

- Normalización de formatos: Convertir los datos en un formato estándar para su fácil manipulación.

- Extracción de información: Identificar y extraer datos importantes de la información recolectada.

- Clasificación y etiquetado: Organizar los datos en categorías para su posterior uso.

Herramientas utilizadas por las arañas web

Las arañas web, también conocidas como bots, utilizan una serie de herramientas para recorrer y analizar páginas web de manera eficiente. Estas herramientas les permiten indexar el contenido de manera ordenada y precisa. Entre las principales herramientas utilizadas por las arañas web, encontramos:

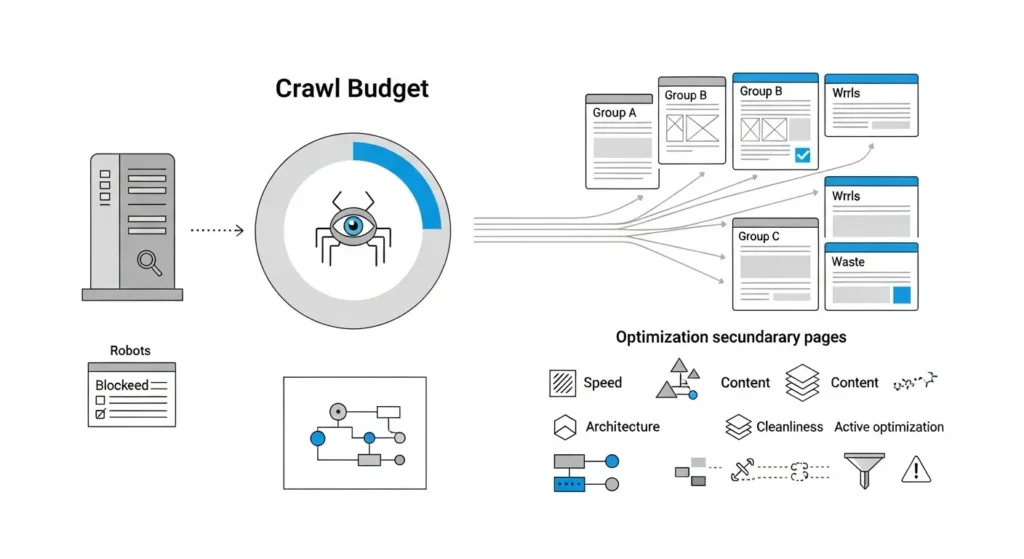

- Robots.txt: Es un archivo de texto que indica a las arañas web qué páginas pueden rastrear en un sitio web y cuáles deben evitar. Es una herramienta fundamental para el control del indexado de un sitio.

- Sitemap XML: Es un archivo que contiene un mapa detallado de la estructura del sitio web, facilitando a las arañas web la indexación de todas las páginas de manera organizada.

- Metaetiquetas: Las arañas web también analizan las metaetiquetas de las páginas para obtener información relevante sobre el contenido, como el título, descripción y palabras clave.

- Análisis de enlaces: Las arañas web siguen los enlaces internos y externos de un sitio web para descubrir nuevas páginas y relacionar la información de manera más completa.

- Crawl budget: Es la cantidad de recursos asignados por los motores de búsqueda para rastrear un sitio web. Las arañas web utilizan esta herramienta para priorizar qué páginas deben indexar con mayor frecuencia.

ROBOTS.TXT

El archivo robots.txt es una herramienta fundamental en el ámbito del posicionamiento web y la optimización para motores de búsqueda. Se trata de un archivo de texto que se sitúa en la raíz del sitio web y que contiene instrucciones para los “crawlers” o arañas web sobre qué áreas del sitio pueden rastrear y indexar, y cuáles deben evitar.

El robots.txt es un elemento clave para el control de la indexación de las páginas web por parte de los motores de búsqueda, ya que permite indicarles qué contenido es relevante y está disponible para ser mostrado en los resultados de búsqueda.

Es importante tener en cuenta que los robots de los motores de búsqueda respetan las indicaciones del archivo robots.txt, por lo que su correcta configuración puede influir significativamente en la visibilidad y posicionamiento de un sitio web en los resultados de búsqueda.

Algunas directivas comunes que se pueden incluir en el archivo robots.txt son:

- User-agent: Permite especificar a qué arañas web se aplican las directivas que se definen a continuación.

- Disallow: Indica qué secciones del sitio web no deben ser rastreadas ni indexadas por los motores de búsqueda.

- Allow: Permite especificar excepciones a las reglas de bloqueo establecidas con Disallow.

- Crawl-delay: Permite definir un retraso en el tiempo entre peticiones consecutivas a nuestro servidor por parte de los buscadores.

En resumen, el archivo robots.txt es una herramienta poderosa que contribuye a la gestión eficiente de la indexación de un sitio web en los motores de búsqueda, permitiendo controlar qué contenido es accesible públicamente y cuál no, en función de los objetivos de visibilidad y posicionamiento de la página.

SITEMAPS XML

Los Sitemaps XML son archivos que contienen una lista de las páginas de un sitio web, facilitando la indexación de su contenido por parte de los motores de búsqueda como Google. Estos archivos permiten a los motores de búsqueda rastrear e identificar todas las URL de un sitio de manera eficiente.

Es fundamental para el SEO contar con un sitemap XML bien estructurado, ya que ayuda a mejorar la visibilidad y la indexación de las páginas de un sitio web. Además, permite especificar la importancia de ciertas URL y la frecuencia con la que deben ser revisadas por los motores de búsqueda.

Al crear un sitemap XML, es importante incluir todas las URL relevantes del sitio, así como tener en cuenta las etiquetas de prioridad, frecuencia de cambio y última modificación. Esto ayuda a los motores de búsqueda a comprender la estructura y el contenido del sitio de manera más detallada.

En resumen, los Sitemaps XML son una herramienta esencial para optimizar la visibilidad de un sitio web en los resultados de búsqueda, ya que facilitan la tarea de indexación de las páginas y mejoran la relevancia de la información para los motores de búsqueda.

METAETIQUETAS

Las metaetiquetas son elementos esenciales dentro del código HTML de una página web que ayudan a los motores de búsqueda a comprender de qué trata el contenido. Aunque no son visibles para los usuarios, desempeñan un papel crucial en el posicionamiento de un sitio en los resultados de búsqueda.

Existen diferentes tipos de metaetiquetas, cada una con un propósito específico. Algunas de las más comunes son:

- Metaetiqueta Title: Esta metaetiqueta especifica el título de la página y es uno de los factores más importantes para el SEO.

- Metaetiqueta Description: Se utiliza para proporcionar una breve descripción del contenido de la página, la cual puede aparecer en los resultados de búsqueda.

- Metaetiqueta Keywords: Aunque su importancia ha disminuido en cuanto a SEO, todavía se utiliza para indicar palabras clave relevantes para el contenido.

- Metaetiqueta Robots: Permite controlar cómo los motores de búsqueda rastrean y indexan una página.

Es fundamental utilizar metaetiquetas de forma estratégica y relevante para mejorar la visibilidad y el posicionamiento de un sitio web en los motores de búsqueda. ¡Aprovecha su potencial para destacar en la web!

Arañas Web: Indexación y clasificaón

Las arañas web juegan un papel fundamental en la indexación y clasificación de contenido en los motores de búsqueda. Su capacidad para recorrer y analizar páginas web de forma automática permite que los usuarios encuentren información relevante de manera rápida y eficiente.

Es importante tener en cuenta la importancia de optimizar nuestros sitios web para garantizar que las arañas puedan acceder y analizar nuestro contenido de manera efectiva. Esto incluye aspectos como la estructura del sitio, el uso de palabras clave relevantes y la calidad del contenido ofrecido.

Comprender el funcionamiento de las arañas web y su importancia en el mundo digital nos permite mejorar la visibilidad y el posicionamiento de nuestras páginas en los resultados de búsqueda, lo que a su vez contribuye al éxito de nuestros proyectos en línea.